캘리포니아에서 열린 연례 I/O 컨퍼런스에서 Google은 새로운 모델과 기존 모델의 업그레이드를 포함하여 AI와 관련된 여러 가지 발표를 했습니다. 가장 흥미로운 발표 중 하나는 실시간으로 작동하고 Google Lens와 Gemini의 기능을 결합하여 주변 정보를 제공하는 다중 모달 도우미인 Project Astra였습니다.

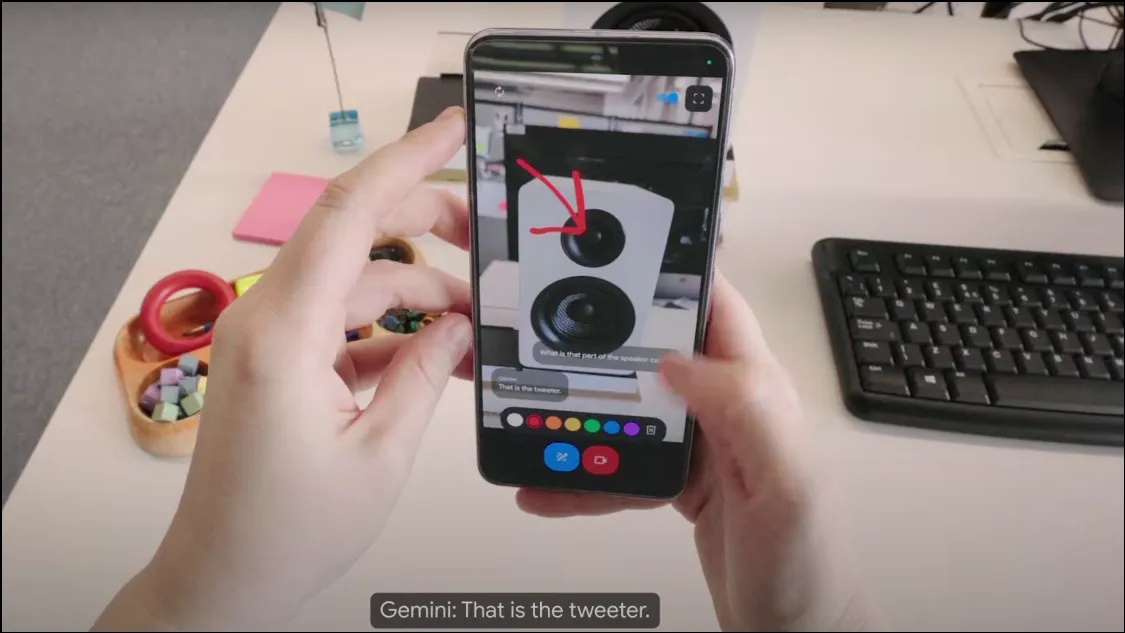

프로젝트 Astra는 어떻게 작동합니까? 이번 컨퍼런스에서 구글은 카메라 기반 챗봇 역할을 하며 기기의 카메라를 이용해 주변 정보를 수집할 수 있는 프로젝트 아스트라(Project Astra)의 초기 버전을 선보였다. 멀티모달 AI 어시스턴트이기 때문에 오디오, 비디오, 이미지를 입력으로 사용하고 이를 기반으로 필요한 출력을 제공할 수 있습니다. Gemini 1.5 Pro 모델에서 실행되므로 믿을 수 없을 만큼 강력합니다.

챗봇은 사물과 주변 환경을 실시간으로 분석하고 문의 사항에 매우 빠르게 답변할 수 있어 인간 비서나 토니 스타크가 사랑하는 JARVIS와 매우 유사합니다. Project Astra는 스마트 안경과 같은 웨어러블 기기에서도 작동합니다. 이는 AI 챗봇이 다양한 장치에 통합될 가능성이 많다는 것을 의미합니다.

Project Astra는 사용되는 컨텍스트를 더 잘 이해하고, 정보를 더 빠르게 처리하고, 더 빠르게 기억할 수 있도록 보관할 수 있습니다. 음성 기능도 이전 Gemini 모델에 비해 훨씬 향상되어 더욱 자연스럽고 인간과 유사한 소리를 들려줍니다.

프로젝트 Astra는 무엇을 할 수 있나요? Google이 선보인 짧은 데모에서는 Project Astra가 달성하는 데 도움이 될 수 있는 것이 많은 것 같습니다. 카메라 렌즈와 마이크를 통해 사물과 위치를 관찰하고 파악하고 이에 대한 정보를 제공할 수 있습니다. 예를 들어, 코드 조각에 휴대폰을 대고 챗봇과 논의하거나 객체와 용도를 식별하도록 요청할 수 있습니다.

마찬가지로 위치 인식 기능 덕분에 Project Astra는 주변을 살펴보는 것만으로도 해당 지역에 대한 정보를 제공할 수 있습니다. 또한 표시된 정보를 유지할 수 있어 사용자가 안경을 찾는 데 도움이 된 데모에서 설명한 것처럼 잘못 배치된 항목을 찾으려는 경우 매우 유용할 수 있습니다.

휴대폰에서 Gemini를 사용하는 것처럼 AI 비서에게 창의적인 아이디어를 요청할 수도 있습니다. 예를 들어, 노래 가사, 밴드 이름 등 무엇이든 물어볼 수 있습니다. 기본적으로 프로젝트 아스트라는 매우 대화적인 방식으로 실시간 정보를 제공할 수 있는 보편적인 AI 비서가 되는 것을 목표로 합니다.

Project Astra는 언제 출시되나요? 현재 Google은 Project Astra의 가용성에 관해 발표하지 않았습니다. 데모에 표시된 버전은 초기 프로토타입이지만 Google은 이러한 기능이 이후 단계에서 기존 Gemini 앱에 통합될 수 있음을 암시했습니다.

Google은 Project Astra를 통해 AI 비서의 발전을 주도하여 AI 비서가 더욱 유용하고 사용하기 쉬워지도록 노력하고 있습니다. 하지만 이 목표를 추구하는 기업은 Google만이 아닙니다. OpenAI는 또한 최근 GPT-4o를 발표하여 ChatGPT 멀티모달을 만들어 기능과 효율성을 향상시켰습니다. ChatGPT의 새로운 음성 모드(곧 출시 예정)는 사용자와 상호 작용하는 동안 장치 카메라의 비디오 입력을 사용할 수도 있습니다.

현재 둘 사이의 차이점은 GPT-4o가 곧 ChatGPT를 실행하는 모든 장치에서 사용할 수 있게 되는 반면, Project Astra는 현재 출시 날짜가 없지만 향후 언젠가 Gemini Live로 사용할 수 있을 것으로 예상된다는 것입니다. GPT-4o 기반 ChatGPT가 더 일찍 제공됨에 따라 Google의 Project Astra가 OpenAI의 더 인기 있는 챗봇과 경쟁할 만큼 충분히 좋을지는 아직 알 수 없습니다.

답글 남기기