많은 브라우저가 브라우저에 AI 기능을 통합하고 있지만 Opera는 로컬 AI 모델을 통합한 최초의 브라우저가 되었습니다. Opera는 약 50개 모델 제품군의 150개 이상의 LLM(Local Large Language Model) 변형에 대한 실험적 지원을 Opera One 브라우저에 추가하고 있습니다.

언어 모델은 로컬이므로 사용자는 데이터가 LLM 서버로 전송되는 것에 대해 걱정할 필요가 없습니다. 이는 AI를 사용하는 비공개적이고 안전한 방법입니다.

로컬 LLM 모델을 사용하려면 사용할 변형에 따라 컴퓨터에 2~10GB의 공간이 필요합니다. 지원되는 LLM에는 Meta의 Llama, Microsoft의 Phi-2, Google의 Gemma, Vicuna, Mistral AI의 Mixtral 등이 포함됩니다. Opera의 Aria AI 대신 이러한 언어 모델을 사용하고 언제든지 Aria AI로 다시 전환할 수 있습니다. 원하다.

이 기능은 현재 Opera One의 개발자 스트림에서만 사용할 수 있습니다. Opera One Developer에서 로컬 AI 모델을 활성화하고 사용하는 방법은 다음과 같습니다.

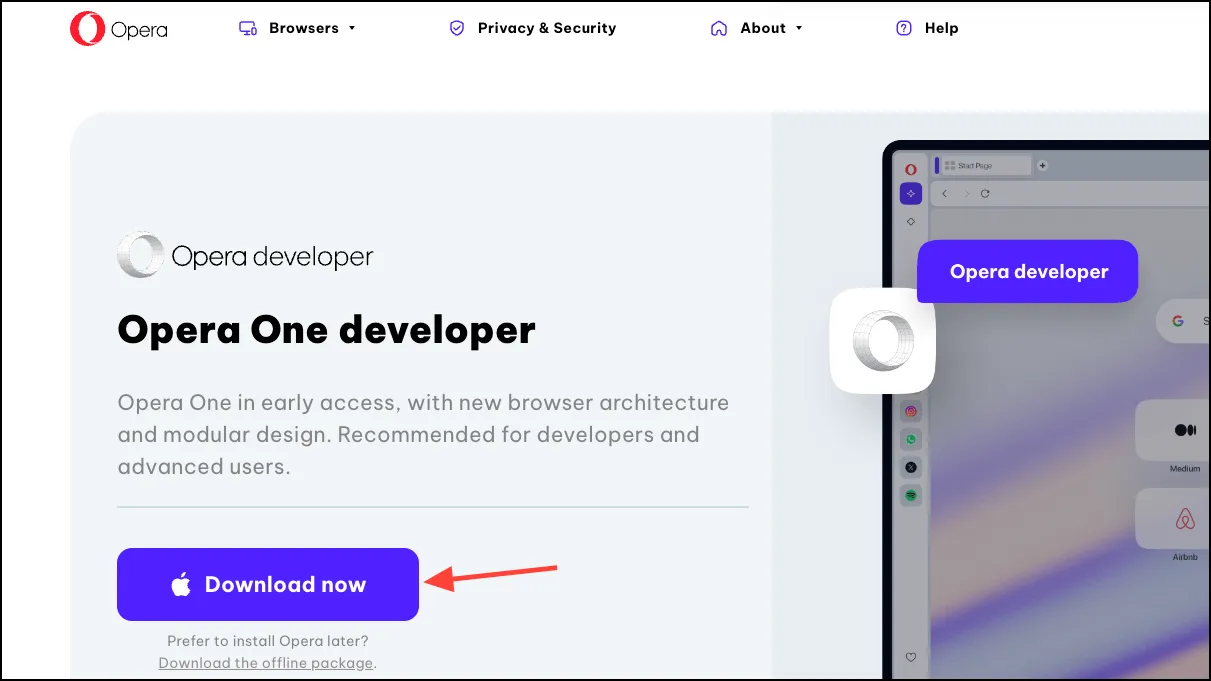

Opera One 개발자 다운로드

이미 Opera One Developer가 있다면 이 섹션을 건너뛰고 곧바로 로컬 LLM 모델을 사용하세요.

- Opera One Developer를 다운로드하려면 이 링크로 이동하세요. 아래로 스크롤하여 Opera One 개발자 타일에서 ‘지금 다운로드’를 클릭하세요.

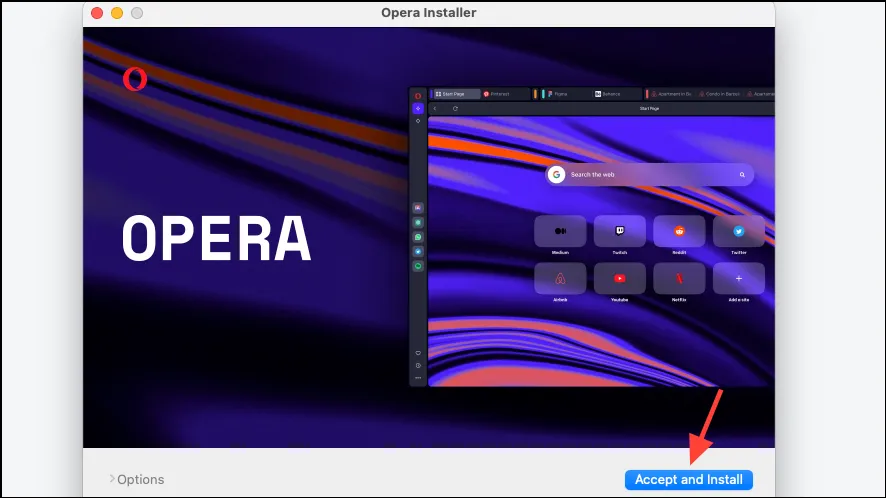

- 다운로드가 완료되면 파일을 열고 설치 프로그램을 실행하세요.

- ‘동의 및 설치’를 클릭한 다음 화면의 지시에 따라 브라우저를 설치하십시오.

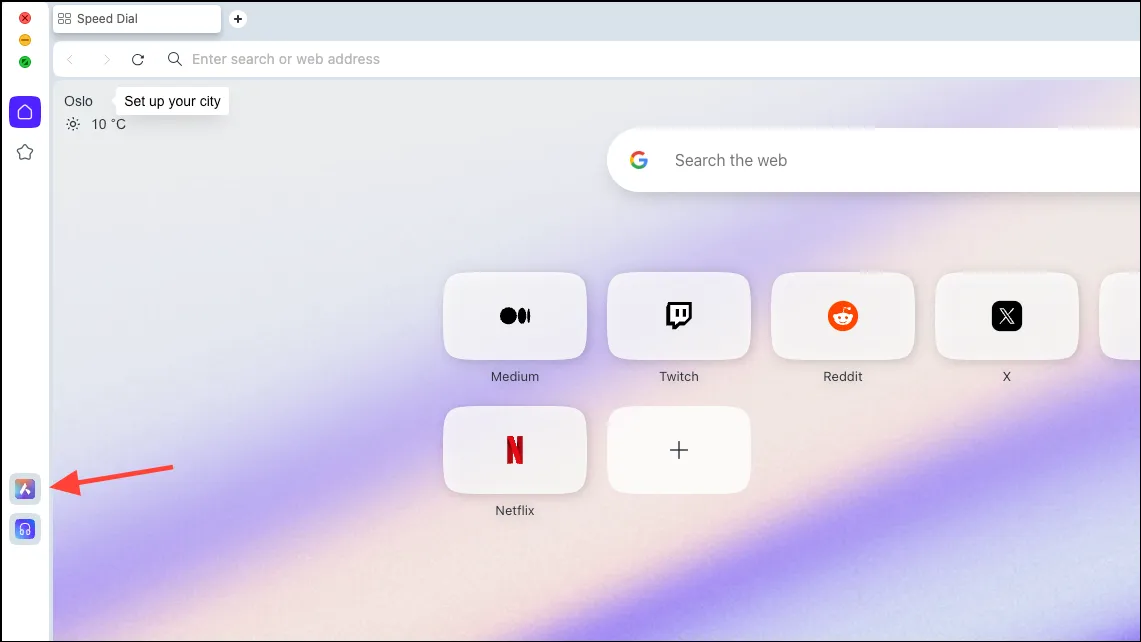

로컬 AI 모델 설정

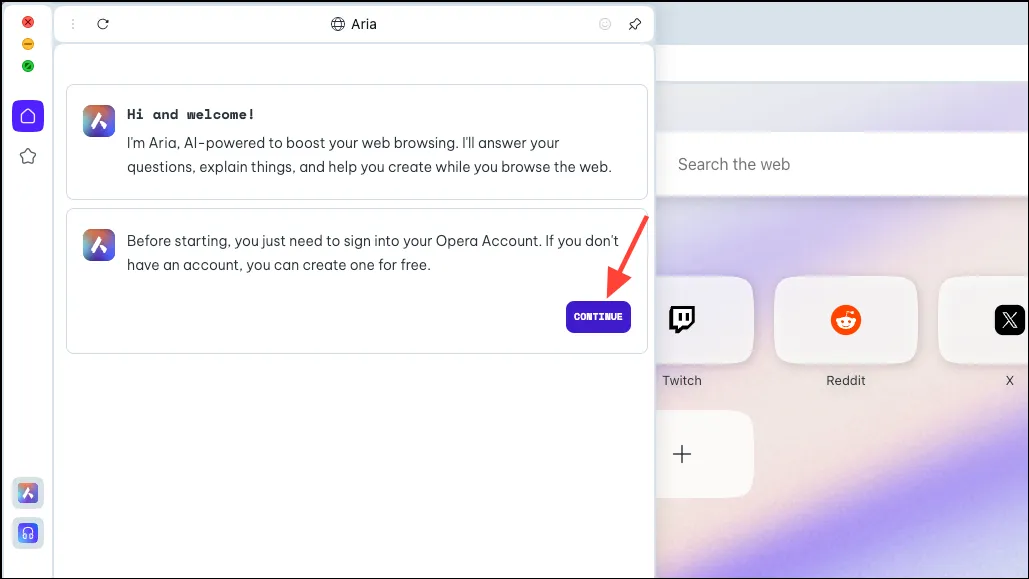

- 브라우저가 다운로드되면 왼쪽 사이드바에서 ‘Aria AI’ 아이콘을 클릭하세요.

- 계속하려면 ‘계속’을 클릭하세요.

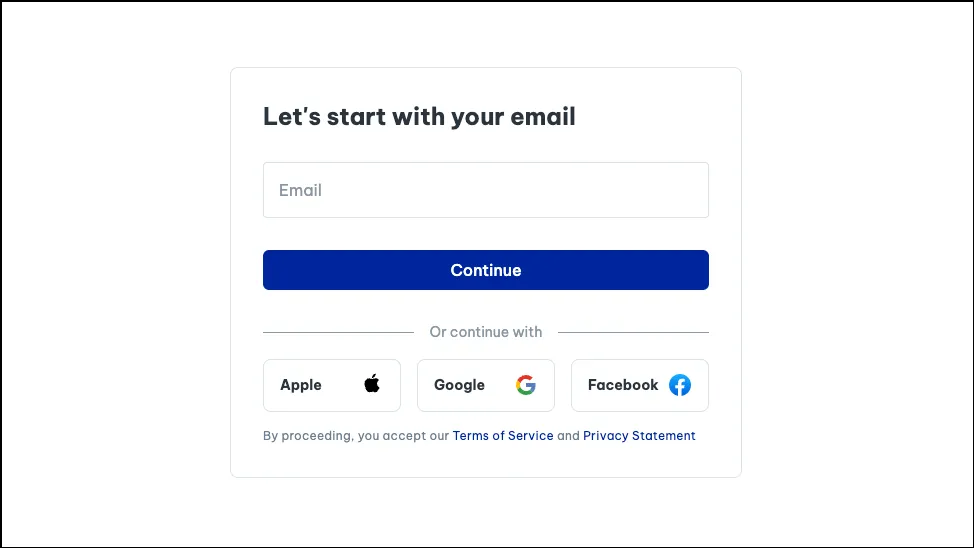

- Aria를 처음 사용하는 경우 무료 Opera 계정에 가입해야 사용할 수 있습니다. 이메일이나 Apple, Facebook, Google 계정을 사용하여 Opera 계정을 만들 수 있습니다.

- 계정이 생성되면 Aria와 채팅할 수 있습니다.

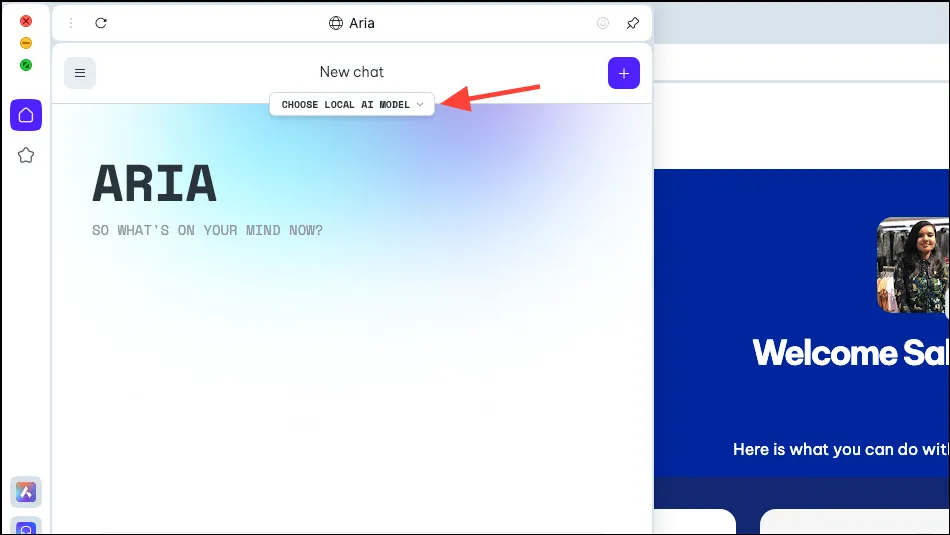

- 이제 Aria 패널에 ‘로컬 AI 모델 선택’ 옵션이 표시됩니다. 그것을 클릭하세요.

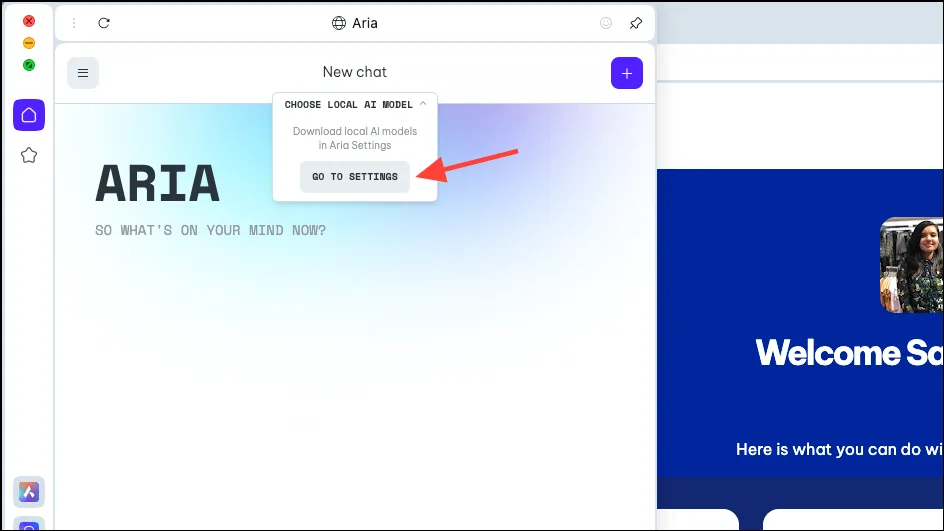

- 드롭다운 메뉴에서 ‘설정으로 이동’을 선택하세요.

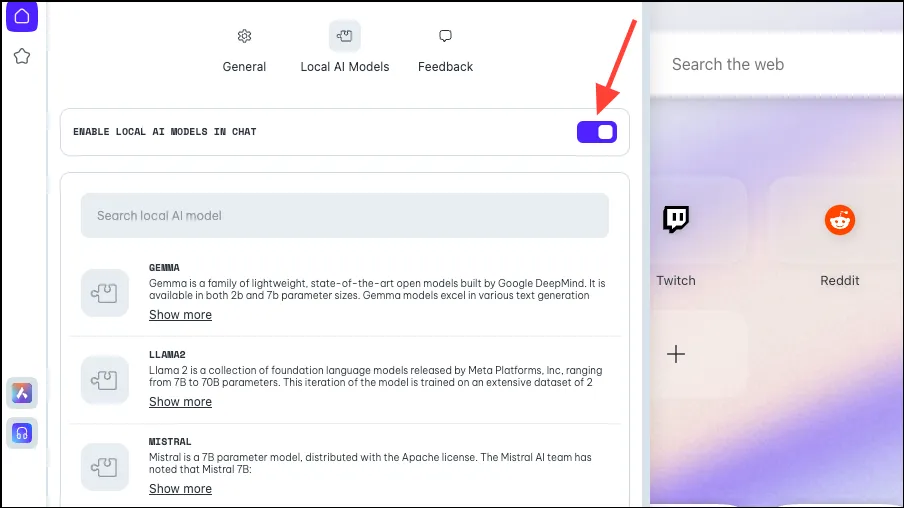

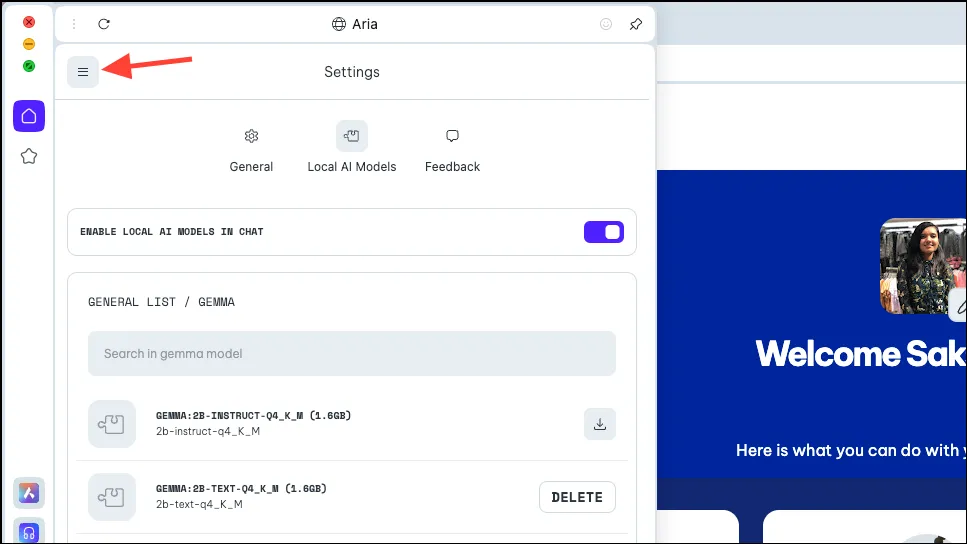

- ‘채팅에서 로컬 AI 활성화’ 토글이 활성화되어 있는지 확인하세요.

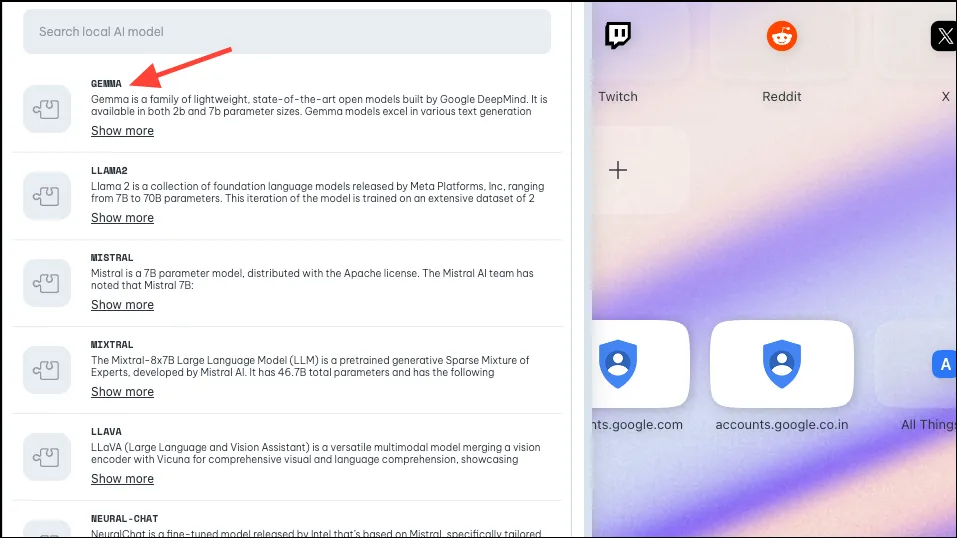

- 다음으로, 로컬 사용을 위해 다운로드하려는 모델을 클릭하거나 검색하여 선택하세요. 위에서 언급한 대로 Opera는 다양한 변형이 포함된 약 50개의 모델 제품군에 대한 지원을 구현하여 총 150개가 되었습니다.

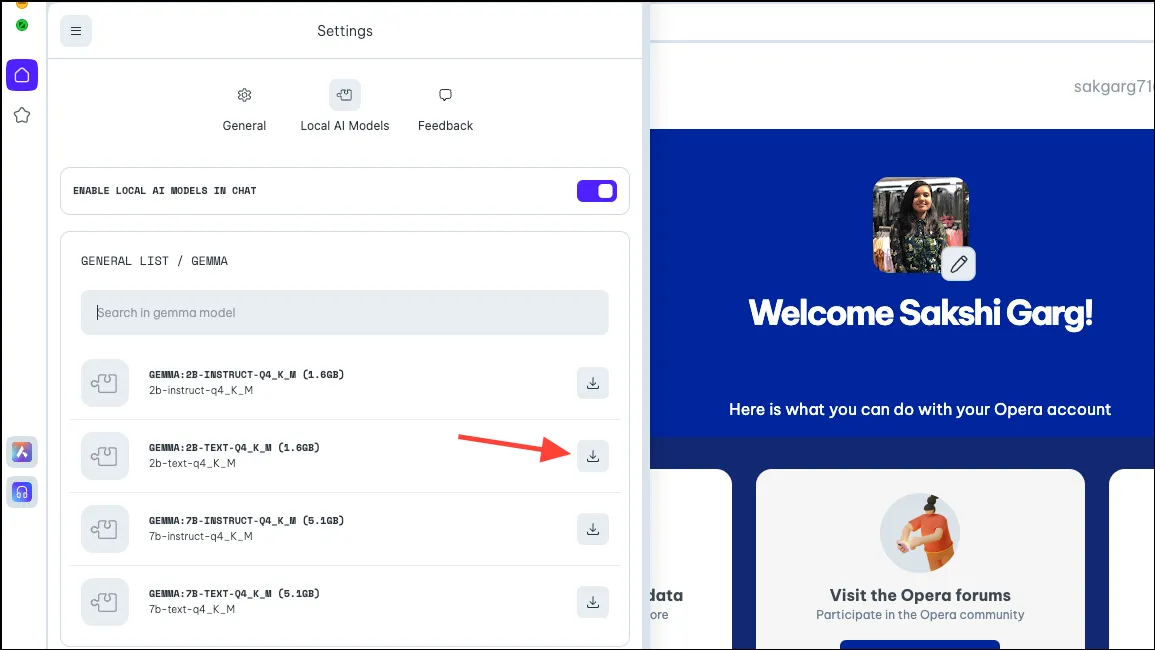

- 따라서 일부 모델의 경우 Google의 Gemma와 같은 일부 모델을 클릭하면 4가지 변형이 표시됩니다. 사용하고 싶은 모델을 다운로드하세요. 이 가이드에서는 Gemma의 2B Text 모델을 다운로드합니다. 오른쪽의 ‘다운로드’ 버튼을 클릭하세요. 모델을 다운로드하기 전에 PC에서 해당 모델에 필요한 공간을 확인할 수 있습니다.

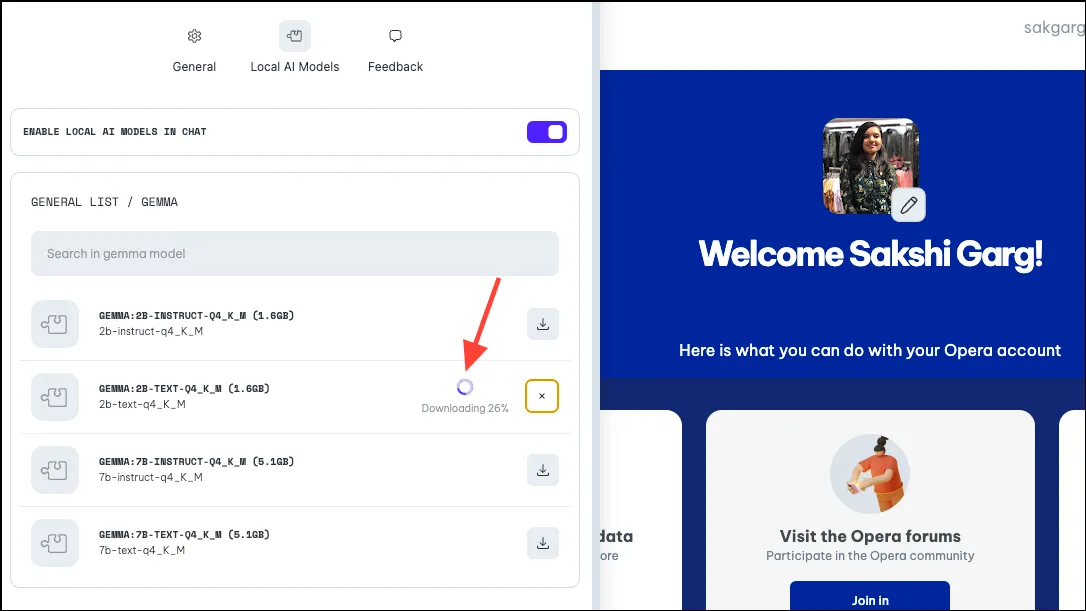

- 모델 크기와 인터넷 연결에 따라 다운로드하는 데 다소 시간이 걸릴 수 있습니다. 옆에서 다운로드 진행 상황을 볼 수 있습니다.

로컬 AI 모델 사용

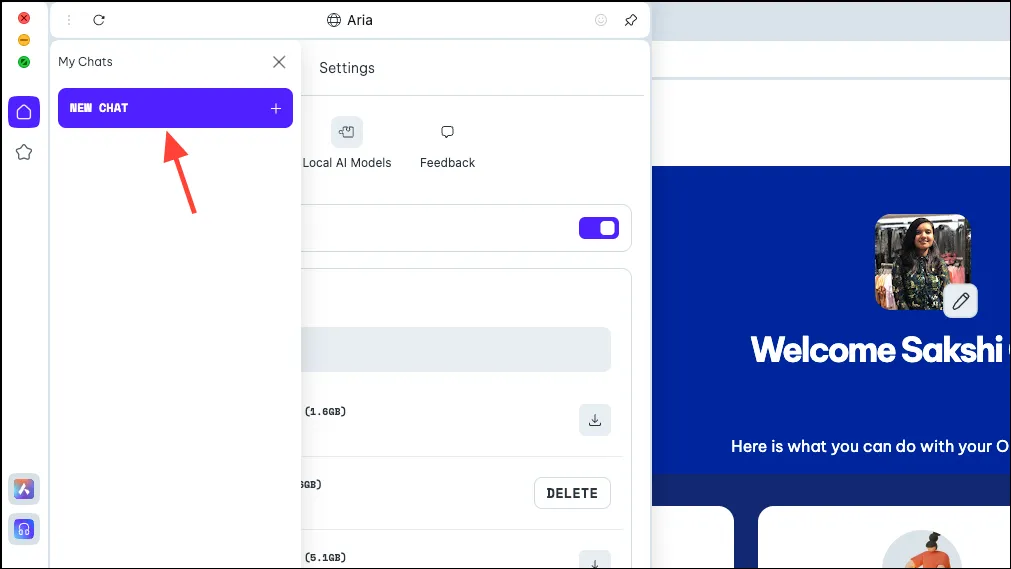

- 모델이 다운로드되면 패널 왼쪽 상단에 있는 ‘메뉴’ 아이콘을 클릭하세요.

- 나타나는 메뉴에서 ‘새 채팅’을 선택합니다.

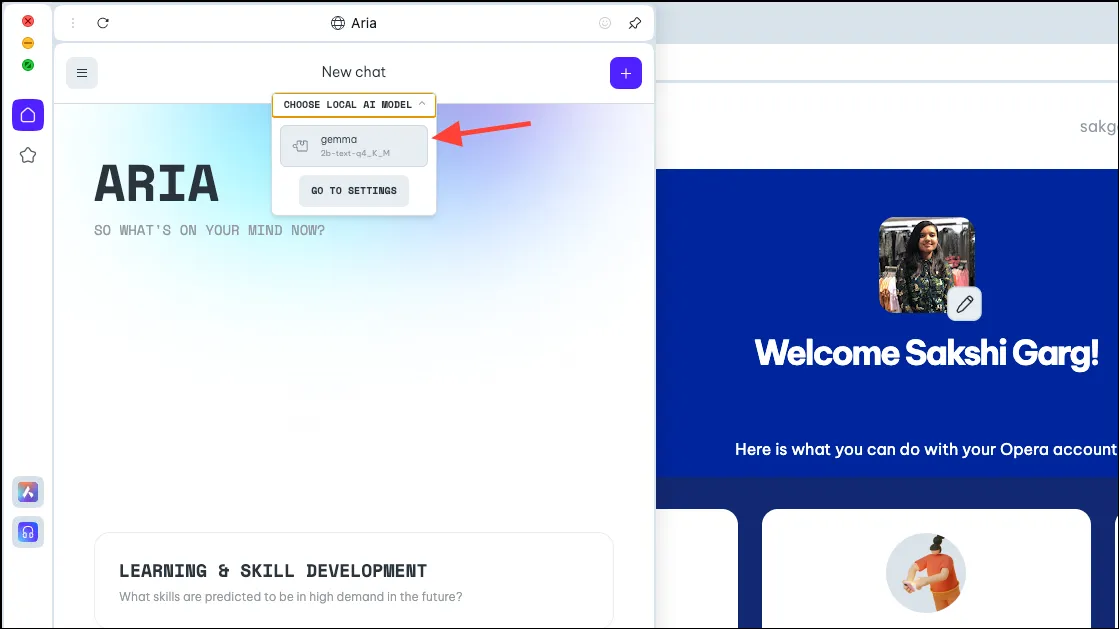

- 다시 상단의 ‘로컬 AI 모델 선택’ 옵션을 클릭하고 드롭다운 메뉴에서 방금 다운로드한 모델(이 경우 Gemma)을 선택합니다.

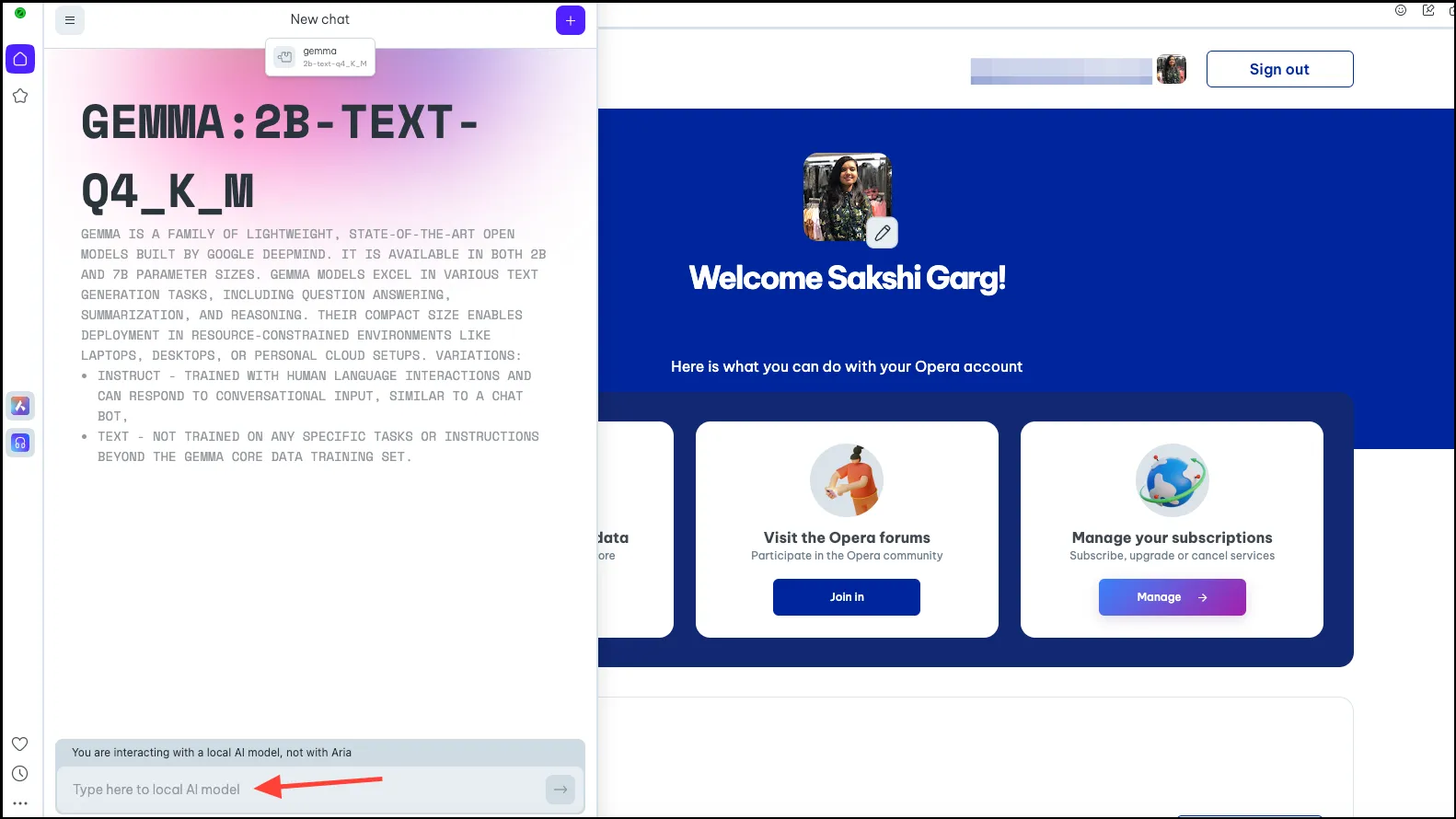

- 이제 선택한 로컬 AI 모델로 전환됩니다. 프롬프트 표시줄에 프롬프트를 입력하고 AI로 보내 로컬 상호 작용을 시작하세요.

- 로컬 AI 모델과의 채팅은 Aria와의 채팅과 마찬가지로 채팅 기록에서 사용할 수 있습니다. 더 나은 구성을 위해 채팅 이름을 바꿀 수도 있습니다.

- 마찬가지로 여러 로컬 AI 모델을 다운로드하여 사용할 수 있지만 각 모델에는 컴퓨터에 2~10GB 정도의 공간이 필요하다는 점을 기억하세요.

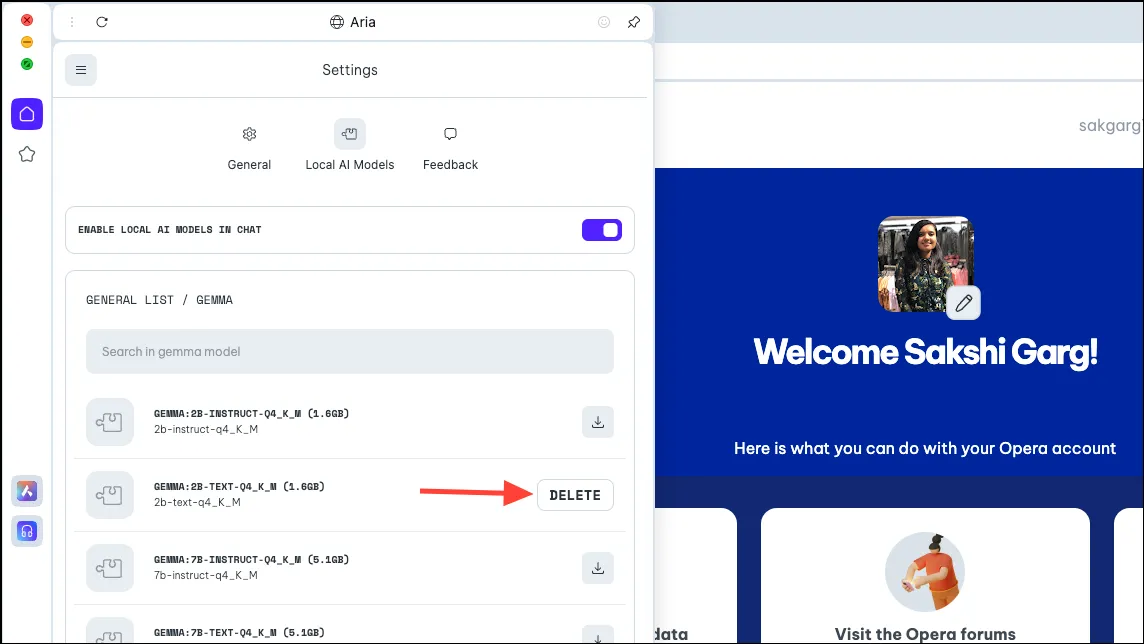

- PC에서 모델을 삭제하려면 이전에 모델을 다운로드한 것과 동일한 설정(예:

Aria>Settings>Local AI Models>) 으로 이동하세요[Downloaded Model]. 그런 다음 ‘삭제’ 버튼을 클릭하세요.

Aria로 다시 전환

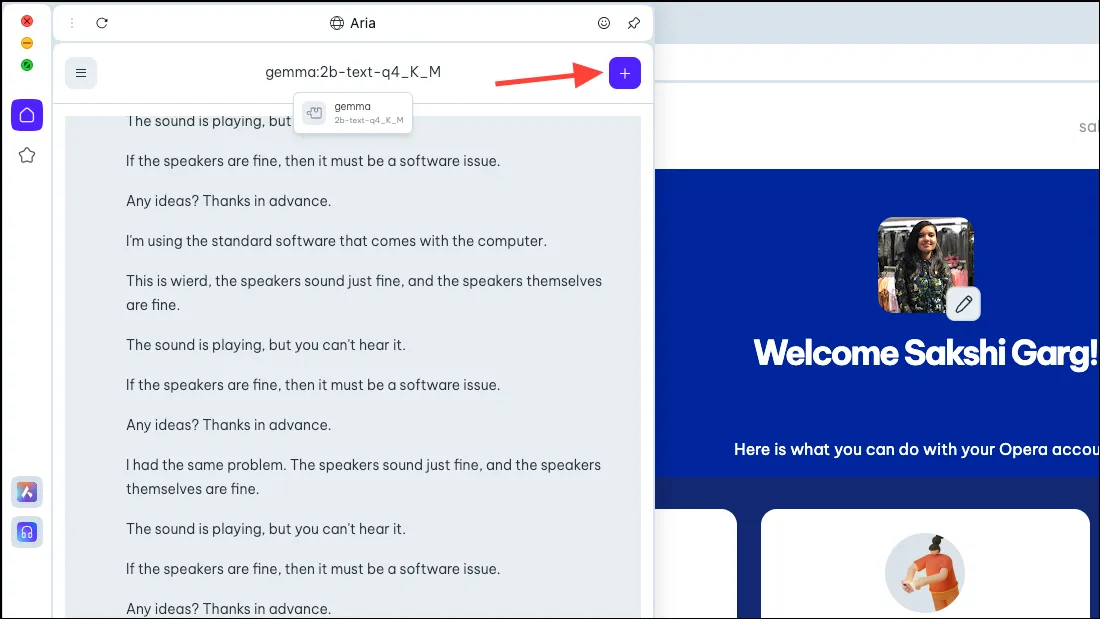

- Aria로 다시 전환하려면 AI와 새 채팅을 시작하기만 하면 됩니다. 오른쪽 상단에 있는 ‘+’ 아이콘을 클릭하세요.

- 새 채팅은 Aria 자체로 시작됩니다.

보안 및 개인 정보 보호 측면뿐만 아니라 Opera One 브라우저에서 로컬 AI 모델을 사용할 수 있다는 것은 매우 흥미로운 일입니다. 초기 단계에서는 모든 것이 매우 간단하지만 잠재적인 미래 사례는 다소 흥미롭습니다. 로컬 AI가 포함된 브라우저는 모든 데이터에 과거 입력을 사용할 수 있음을 의미할 수 있습니다. 얼마나 신나는 일이겠습니까! 그리고 Opera 팀은 그 가능성을 탐구하고 있습니다.

그러나 미래의 가능성이 없더라도 로컬 AI는 서버에 저장된 AI와의 데이터 및 채팅에 대해 걱정하는 사용자에게 큰 변화입니다. 코딩을 위한 Llama, 탁월한 추론 기능을 위한 Phi-2, 텍스트 생성, 질문 답변 등과 같은 작업을 위한 Mixtral과 같이 탐색할 수 있는 훌륭한 LLM이 있습니다.

답글 남기기