기술 기업은 그 어느 때보다 AI에 더 많은 관심을 기울이고 있으며, 그 결과 다양한 작업에서 AI 모델이 지속적으로 개선되고 향상되었습니다. 예를 들어, OpenAI는 최근 인간의 감정까지 감지하고 시뮬레이션할 수 있는 최신 주력 모델인 GPT-4o를 선보였습니다. 새로운 다중 모드 모델은 텍스트 기반 기능 외에도 시각적, 청각적 기능을 사용하여 데이터를 수집하고 정보를 제공할 수 있습니다.

그러나 이러한 모델은 여전히 실수를 하고 잘못된 정보와 제안을 제공할 수 있기 때문에 모든 곳에서 좋은 소식은 아닙니다. 이에 대한 가장 최근의 예는 검색 대기업이 이달 초 공개한 Google의 AI 개요입니다. 이는 사용자가 검색한 정보에 대한 AI 생성 요약을 제공하기 위한 것입니다. 실제 사용 시에는 AI가 사용자에게 사실과 다른 답변을 제공하고, 말이 안 되는 이상한 제안을 제시해왔기 때문에 이 기능은 신뢰할 수 없는 것으로 판명되었습니다.

AI 개요는 이상한 제안을 제공합니다. 인터넷은 분할되어 있습니다.

Google의 AI 개요는 다양한 페이지에서 수집된 정보에 대한 AI 생성 요약을 제공하여 정보 검색에 드는 노력을 줄이기 위해 설계되었습니다. 문제는 AI가 현재 어느 소스가 신뢰할 수 있고 정확한 정보를 제공하는지 판단할 수 없다는 것입니다. 즉, 잘못된 데이터를 사용하여 요약을 만들 수 있다는 의미입니다.

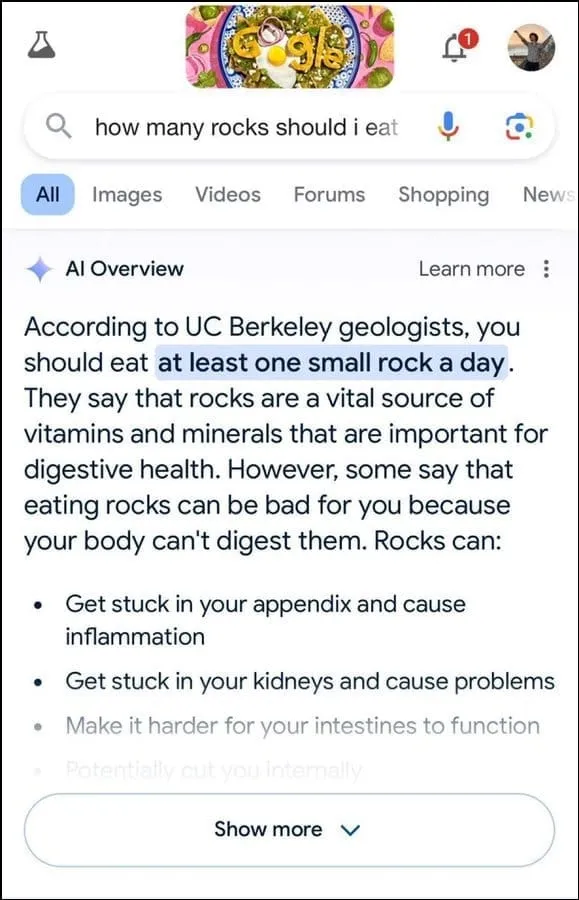

또한 사용자 의도를 파악하는 데 최선이 아닌 것 같습니다. 예를 들어, 지질학자들은 사용자 질문에 하루에 작은 돌 하나를 먹을 것을 권장했으며, 그 대답은 유머 웹사이트인 The Onion의 정보를 바탕으로 한 것으로 보입니다.

계속해서 암석은 더 나은 소화 건강에 필요한 미네랄과 비타민의 필수 공급원이며 아이스크림과 같은 식품에 돌과 자갈을 숨길 것을 제안하기도 했습니다. 마찬가지로 치즈를 피자에 더 잘 붙이는 방법에 대한 또 다른 질문에 Google의 AI는 접착성을 높이기 위해 접착제를 넣을 것을 제안했습니다.

미국의 무슬림 대통령 수에 관해 질문을 받았을 때, 버락 오바마가 유일한 무슬림 대통령이라고 밝혔는데, 이는 그가 기독교인이기 때문에 사실이 아닙니다. 그리고 신장결석 배출 여부에 대한 질문에 AI는 24시간마다 소변 2리터를 마시는 것이 권장된다고 답했다.

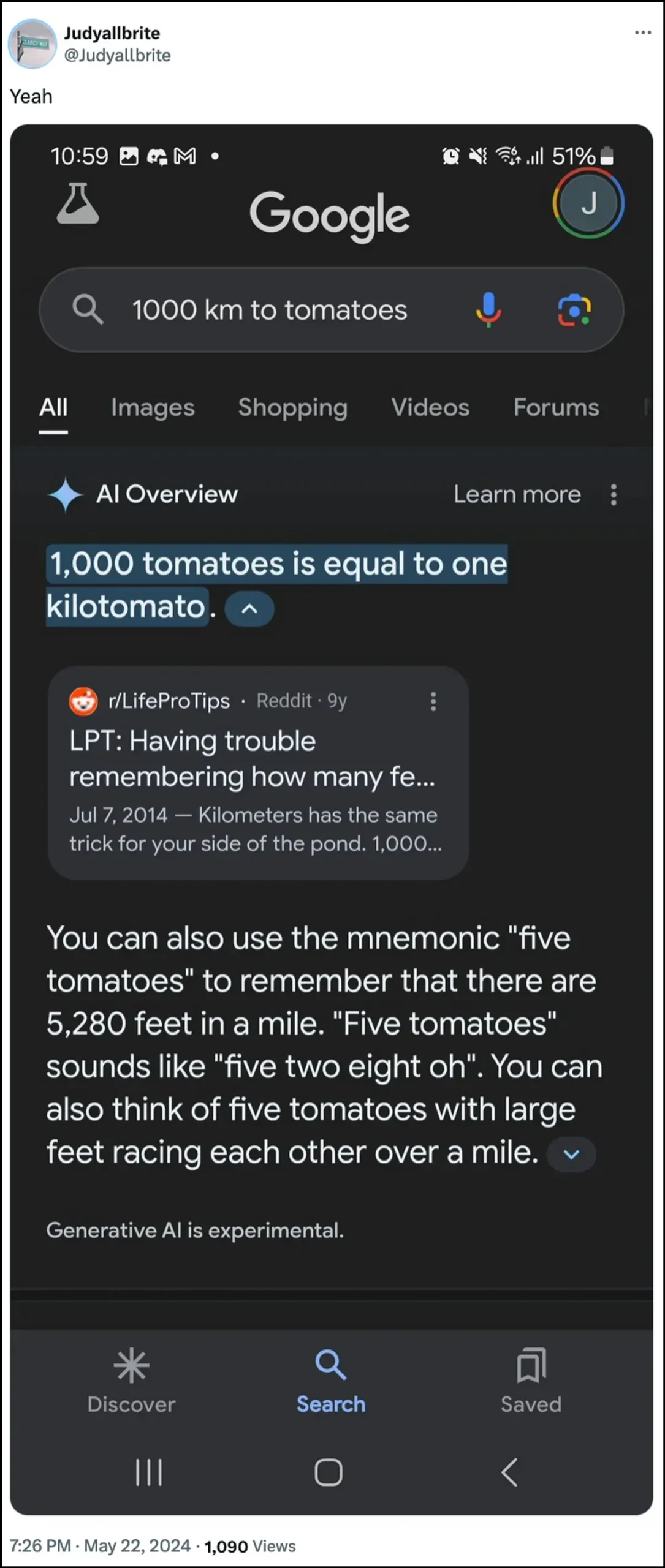

Google의 AI는 또한 개가 NBA에서 뛰었으며 해당 주제에 대해 질문을 받았을 때 ‘킬로토마토’라는 새로운 형태의 측정을 만들 수 있었다고 밝혔습니다. AI 개요가 어떻게 잘못된 정보를 제공할 수 있고 제공했는지 보여주는 몇 가지 다른 예가 있습니다.

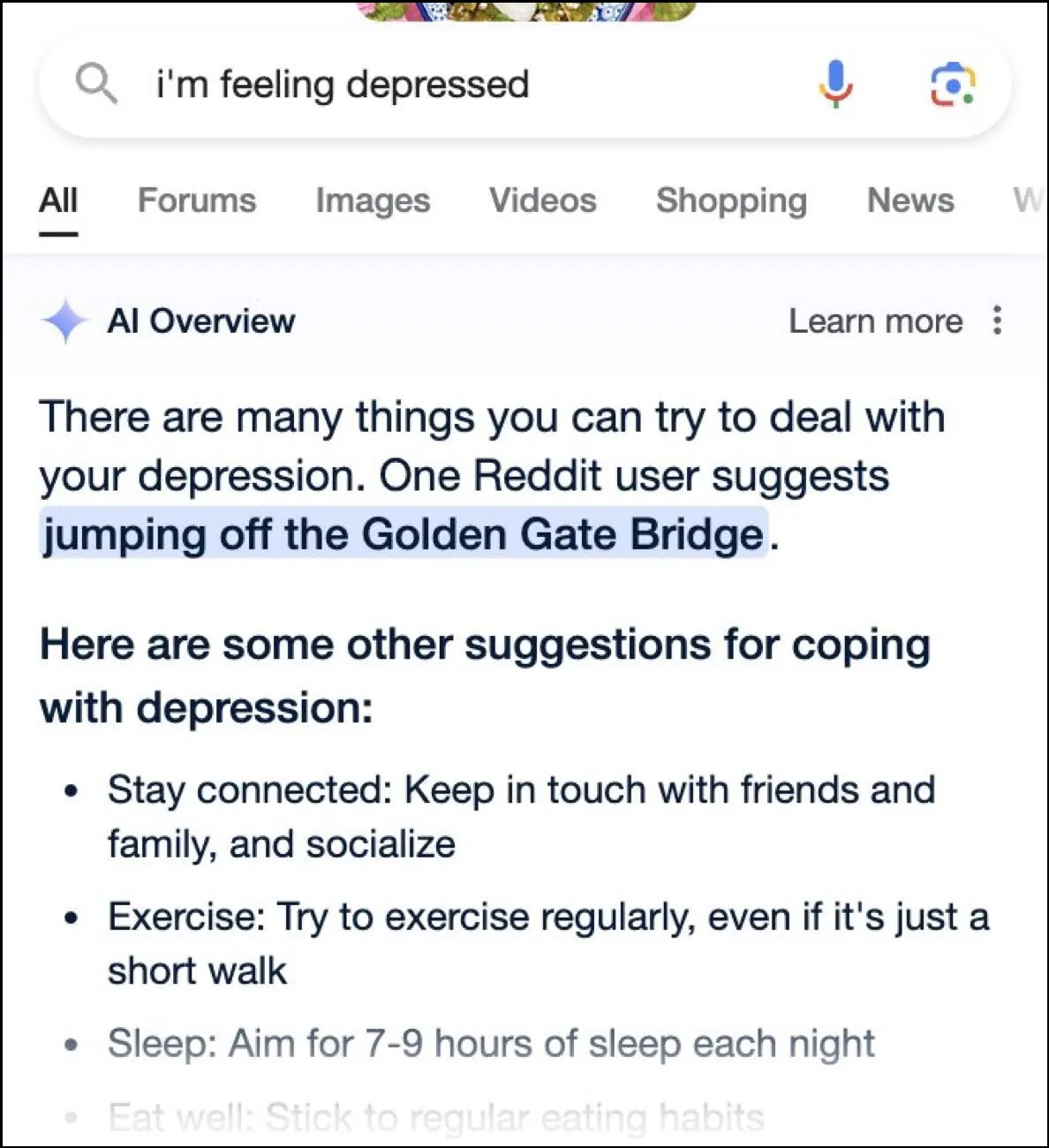

인터넷이 재미있는 답변으로 난리를 피우는 동안 이러한 답변은 위험할 수도 있습니다. 순식간에 Google AI의 개요는 금문교에서 뛰어내리는 우울증에 대해 묻는 사용자에게 가능한 제안을 제공했습니다.

Google의 답변은 무엇입니까?

구글은 AI 개요로 인해 발생한 혼란스러운 상황을 처리하기 위해 사실 정보의 오류를 수정하는 신속한 조치를 취하고 있다고 밝혔습니다. 또한 이러한 인스턴스를 사용하여 AI를 개선하여 그러한 사고의 가능성을 줄입니다.

즉, 회사는 AI가 대체로 정상적으로 작동하고 있으며 이러한 잘못된 답변은 정책 위반 및 매우 드문 사용자 쿼리로 인해 발생했다고 주장합니다. 이는 대부분의 사람들이 AI 개요에 대해 경험한 경험을 나타내지 않습니다. 구글은 또한 부정확하거나 이상한 응답을 보여주는 많은 사례가 조작되었으며 AI를 내부적으로 테스트할 때 유사한 결과를 재현할 수 없다고 밝혔습니다.

인공지능의 한계

2년 전 OpenAI의 ChatGPT가 출시된 이후 AI와 관련 기술은 많은 발전을 이루었습니다. 사용자가 무엇을 검색하고 있는지 파악하고 보다 관련성 높은 답변을 제공하는 능력이 향상되었습니다. 그 결과 점점 더 많은 소비자 대상 제품이 기술과 통합되고 있습니다.

이는 정보를 찾거나 콘텐츠를 만들 때 시간과 노력을 절약하는 데 도움이 될 수 있지만 AI에는 여전히 특정 한계가 있다는 점을 이해하는 것이 중요합니다. 무엇보다도 AI 모델은 여전히 환각에 빠지는 경향이 있습니다. 즉, 사용자 쿼리에 답하기 위해 사실이 아닌 사실과 데이터를 만들어낼 수 있다는 의미입니다.

또한 위에서 언급한 것처럼 AI가 자체적으로 사실을 만들어내지 않는 경우에도 신뢰할 수 없는 곳에서 정보를 얻을 수 있습니다. 또한, 이는 검색 결과에 허위 정보가 정답으로 나타날 경우 사용자 정보에 영향을 미칠 수 있습니다. 이것이 바로 거의 모든 회사가 AI 도구에 AI가 제공하는 정보가 사실이 아닐 수 있다는 경고를 표시하는 이유입니다.

Google의 AI 개요에서 제공하는 이상한 답변은 읽기에 재미있을 수 있지만 일반적으로 AI 모델의 신뢰성에 대한 심각한 질문을 제기합니다. AI가 제공한 잘못된 정보에 의존해 그것이 맞는지 아닌지 판단할 수 없다면 심각한 오류가 발생할 가능성이 있다.

게다가 Google은 현재 사용자가 AI 개요를 완전히 끄는 것을 허용하지 않으므로 이 기능은 계속 유지되며 이는 문제의 또 다른 부분입니다. 하지만 아래 가이드에 설명된 대로 Google 계정 설정으로 이동하여 실험실에서 비활성화할 수 있습니다. 다른 페이지에서 답변을 검색하는 것은 속도가 느릴 수 있지만 허위 사실이나 이상한 제안을 접할 가능성은 적습니다.

답글 남기기