컴퓨터에서 LLM(Large Language Models)을 실행하려면 가장 쉬운 방법 중 하나는 Ollama를 사용하는 것입니다. Ollama는 사용자 정의가 가능하고 쉽게 액세스할 수 있는 AI 경험을 제공하는 강력한 오픈 소스 플랫폼입니다. 클라우드 기반 플랫폼에 의존하거나 기술적 전문 지식이 필요하지 않고도 다양한 LLM을 쉽게 다운로드, 설치 및 상호 작용할 수 있습니다.

위의 장점 외에도 Ollama는 매우 가볍고 정기적으로 업데이트되므로 로컬 머신에서 LLM을 빌드하고 관리하는 데 매우 적합합니다. 따라서 외부 서버나 복잡한 구성이 필요하지 않습니다. Ollama는 Windows, Linux, macOS를 포함한 여러 운영 체제와 다양한 Docker 환경도 지원합니다.

Ollama 다운로드 및 설치

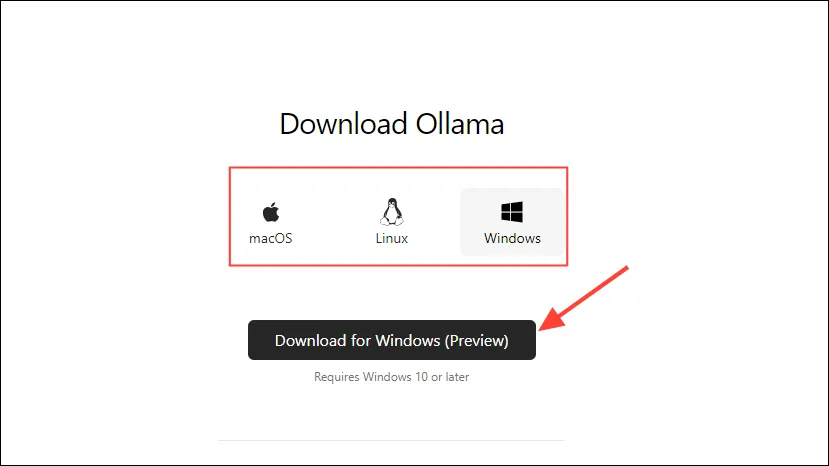

- 먼저 Ollama 다운로드 페이지로 가서 OS를 선택한 후 ‘다운로드’ 버튼을 클릭하세요.

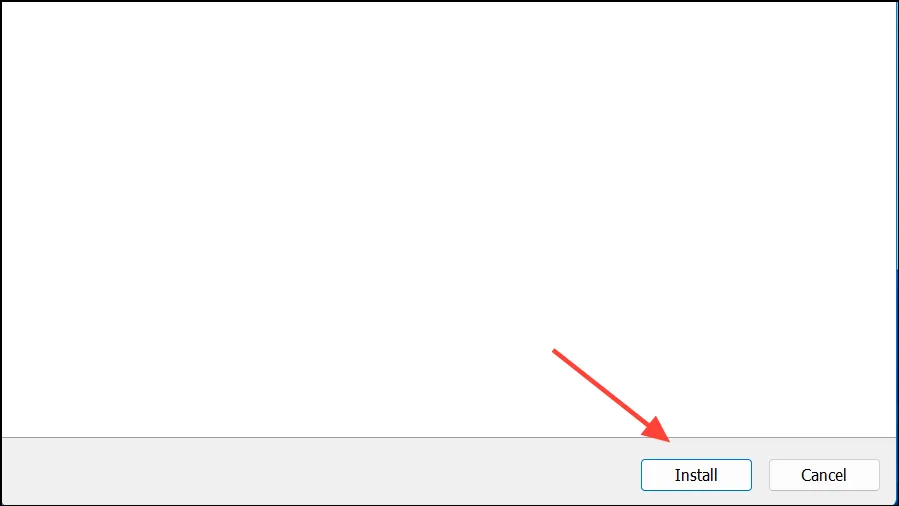

- 다운로드가 완료되면, 그것을 열고 당신의 기계에 설치하세요. 설치가 완료되면 설치 프로그램이 자동으로 닫힙니다.

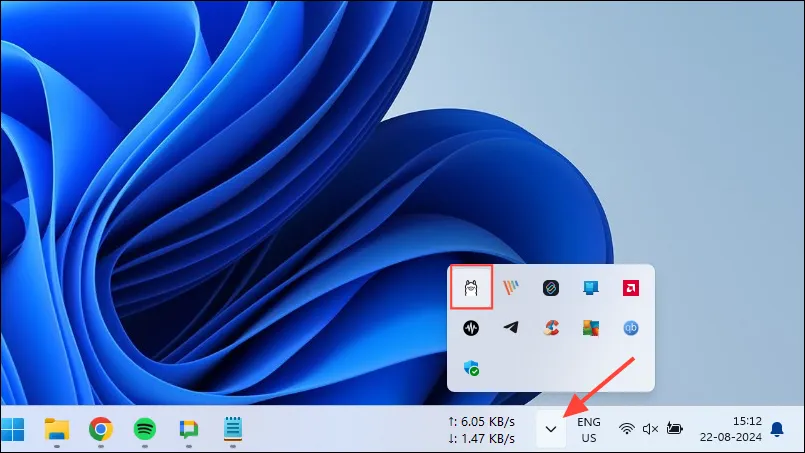

- Windows에서는 작업 표시줄 오버플로 버튼을 클릭하여 숨겨진 아이콘을 확인하여 Ollama가 실행 중인지 확인할 수 있습니다.

Ollama 사용자 정의 및 사용

Ollama가 컴퓨터에 설치되면 가장 먼저 해야 할 일은 데이터를 저장하는 위치를 변경하는 것입니다. 기본적으로 저장 위치는 C:\Users\%username%\.ollama\models이지만 AI 모델은 상당히 클 수 있으므로 C 드라이브가 빠르게 가득 찰 수 있습니다. 그렇게 하려면,

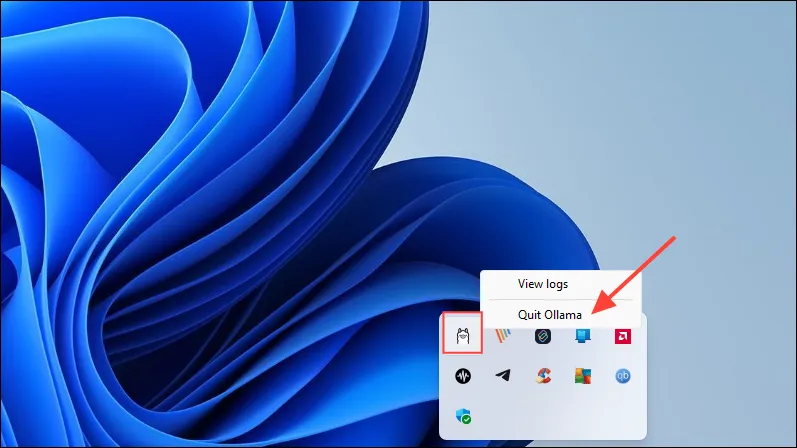

- 먼저, 작업 표시줄에 있는 Ollama 아이콘을 클릭하고 ‘Ollama 종료’를 클릭하세요.

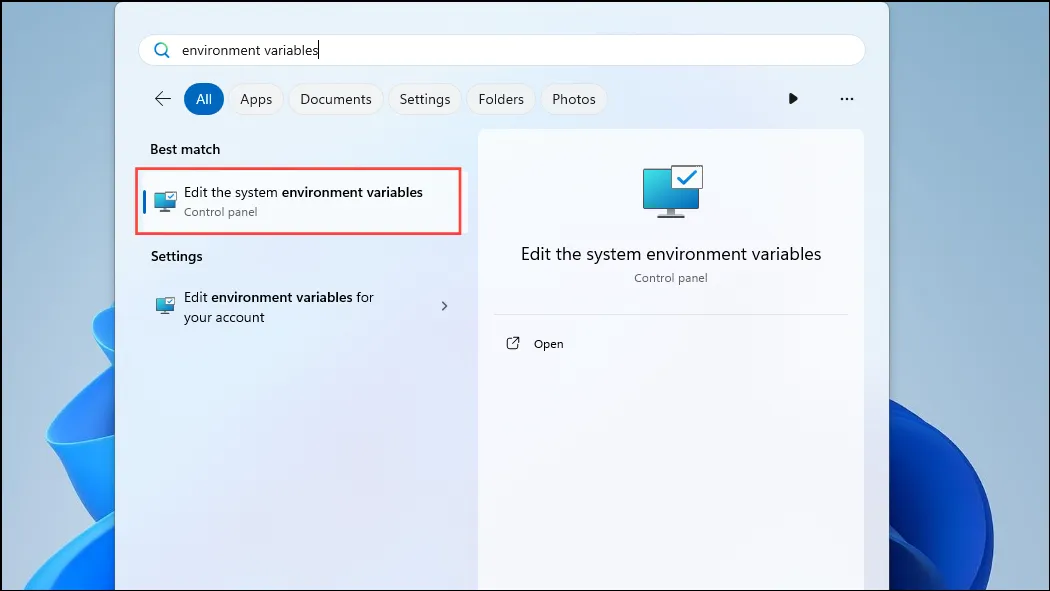

- Ollama를 종료한 후 시작 메뉴를 열고

environment variables‘시스템 환경 변수 편집’을 입력하고 클릭합니다.

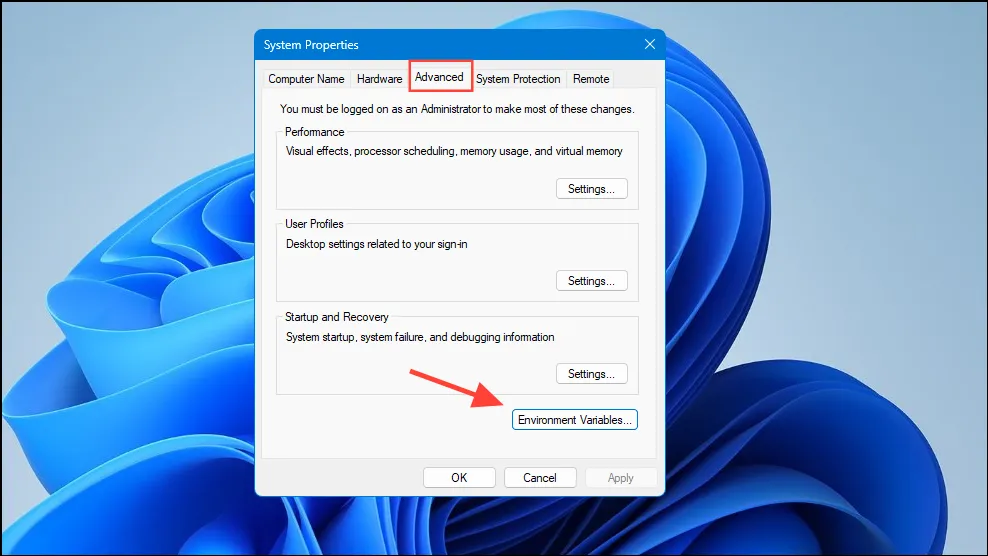

- 시스템 변수 대화 상자가 열리면 ‘고급’ 탭에서 ‘환경 변수’ 버튼을 클릭합니다.

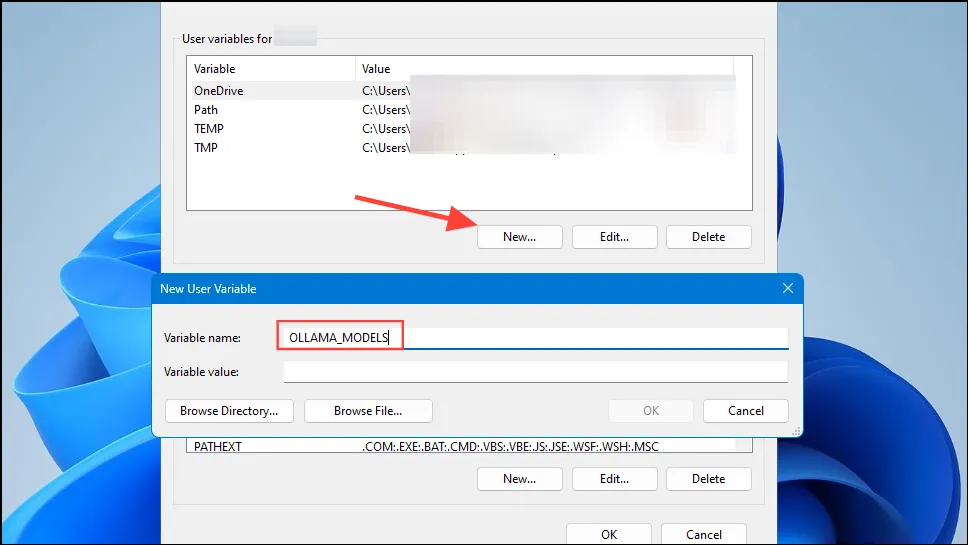

- 사용자 계정의 ‘새로 만들기’ 버튼을 클릭하고

OLLAMA_MODELS‘변수 이름’ 필드에 이름이 지정된 변수를 만듭니다.

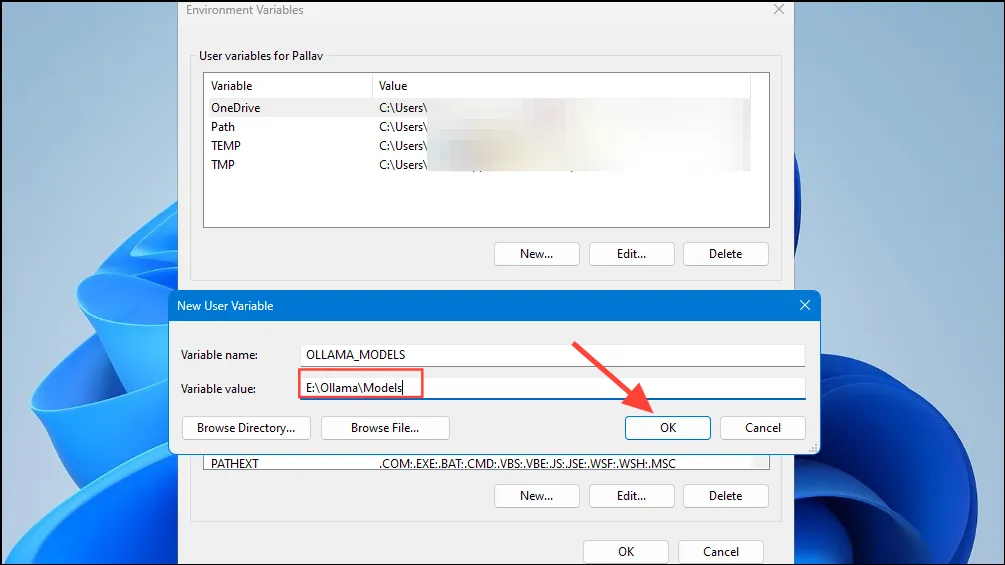

- 그런 다음 Ollama가 모델을 저장할 디렉토리의 위치를 ’변수 값’ 필드에 입력합니다. 그런 다음 시작 메뉴에서 Ollama를 시작하기 전에 ‘확인’ 버튼을 클릭합니다.

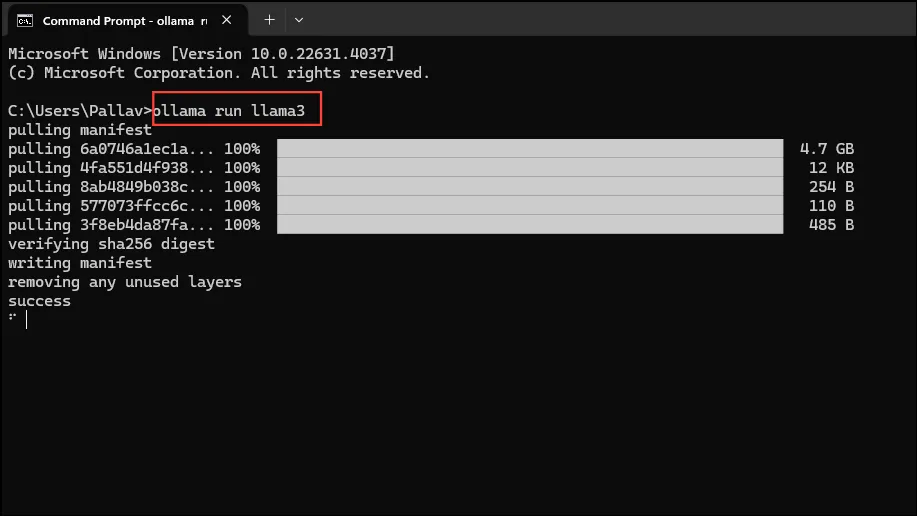

- 이제 Ollama를 사용할 준비가 되었으며, Meta의 Llama 3 8B, 회사의 최신 오픈소스 AI 모델로 이를 수행할 수 있습니다. 모델을 실행하려면 시작 메뉴에서 명령 프롬프트, Powershell 또는 Windows Terminal 창을 시작합니다.

- 명령 프롬프트 창이 열리면 입력

ollama run llama3하고 Enter를 누릅니다. 모델은 5GB에 가까워서 다운로드하는 데 시간이 걸립니다.

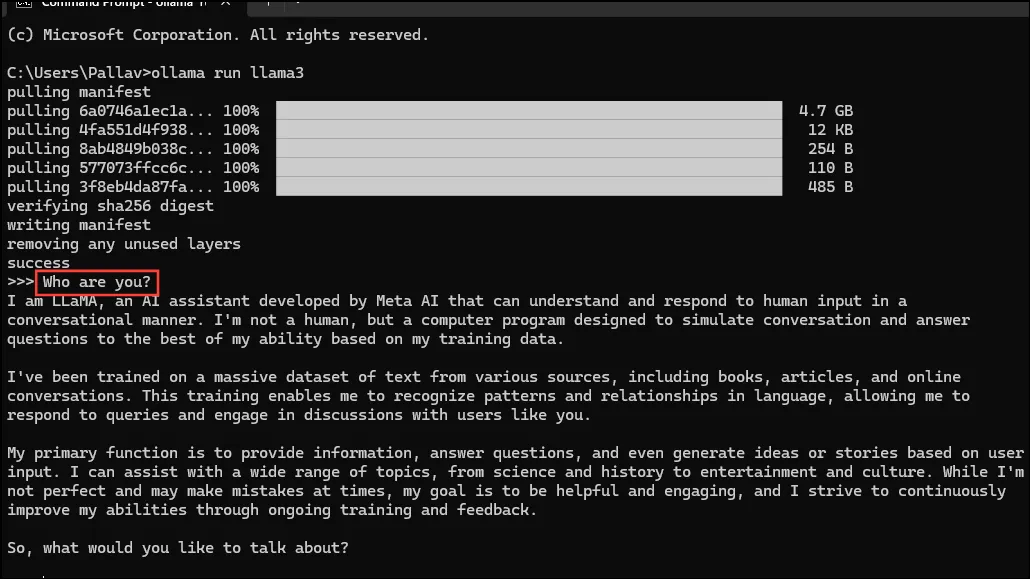

- 다운로드가 완료되면 Llama 3 8B를 사용하여 명령줄 창에서 직접 대화할 수 있습니다. 예를 들어 모델에 질문

Who are you?하고 Enter를 눌러 답변을 받을 수 있습니다.

- 이제 대화를 계속하고 AI 모델에게 다양한 주제에 대해 질문할 수 있습니다. Llama 3는 실수를 하고 환각을 볼 수 있으므로 사용할 때는 조심해야 한다는 점을 명심하세요.

- Ollama 모델 라이브러리 페이지를 방문하여 다른 모델을 시도해 볼 수도 있습니다. 또한 Ollama가 제공하는 다양한 기능을 시도해 볼 수 있는 다양한 명령이 있습니다.

- 모델을 실행하는 동안 세션 변수 설정, 모델 정보 표시, 세션 저장 등 다양한 작업을 수행할 수도 있습니다.

- Ollama는 또한 멀티모달 AI 모델을 활용하여 이미지를 인식할 수 있도록 합니다. 예를 들어, LLava 모델은 DALLE-3에서 생성된 이미지를 인식할 수 있습니다. 이미지를 자세히 설명할 수 있습니다.

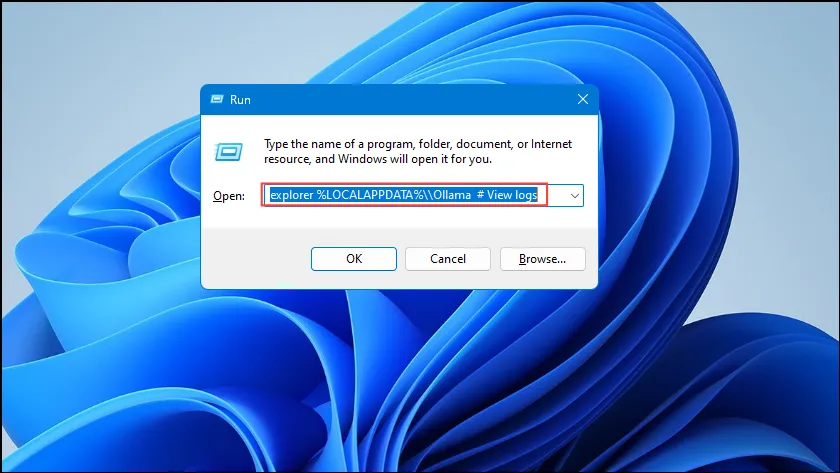

- Ollama를 실행하는 동안 오류가 발생하면 로그를 확인하여 문제가 무엇인지 알아낼 수 있습니다.

Win + R바로가기를 사용하여 실행 대화 상자를 열고explorer %LOCALAPPDATA%\\Ollama # View logsEnter를 누르기 전에 대화 상자 안에 입력합니다.

explorer %LOCALAPPDATA%\\Programs\\Ollama또한 및 와 같은 다른 명령을 사용하여explorer %HOMEPATH%\\.ollama바이너리, 모델 및 구성 저장 위치를 확인할 수 있습니다.

알아두어야 할 사항

- Ollama는 AI 모델을 실행하기 위해 GPU를 자동으로 감지하지만 여러 GPU가 있는 머신에서는 잘못된 GPU를 선택할 수 있습니다. 이를 방지하려면 Nvidia 제어판을 열고 디스플레이를 ‘Nvidia GPU 전용’으로 설정하세요.

- 디스플레이 모드는 일부 기기에서 사용할 수 없으며, 컴퓨터를 외부 디스플레이에 연결한 경우에도 사용할 수 없습니다.

- Windows에서는 작업 관리자를 사용하여 Ollama가 올바른 GPU를 사용하는지 확인할 수 있습니다. 작업 관리자는 GPU 사용량을 표시하고 어떤 GPU가 사용 중인지 알려줍니다.

- macOS와 Linux에 Ollama를 설치하는 것은 Windows와 약간 다르지만, LLM을 실행하는 프로세스는 매우 비슷합니다.

답글 남기기