OpenAI는 최근 2022년에 처음 출시된 유명한 AI 기반 챗봇인 ChatGPT를 지원하는 엔진의 새로운 플래그십 모델인 GPT-4o 모델을 발표했습니다. 훨씬 더 자연스러워요.

GPT-4o에서 ‘o’는 ‘omni’를 의미합니다. 텍스트, 이미지, 오디오를 단일 모델로 결합하기 때문입니다. GPT-4 Turbo 모델에 비해 지능과 추론 전면에는 개선이 없지만 새로운 업데이트가 많이 있습니다. 더 빠르고 인간적인 반응을 제공하도록 설계되었으며 감정을 시뮬레이션할 수도 있습니다. 또한 시각적 및 오디오 입력을 이해하는 속도도 상당히 빠릅니다. 이 심층 분석에서는 GPT-4o가 제공하는 기능과 이것이 AI 비서와 상호 작용하는 방식을 어떻게 혁신할지 살펴보겠습니다. 자, 우리와 함께 시작해 보세요!

GPT-4o가 훨씬 더 빠릅니다.

GPT-4o 모델을 사용하면 ChatGPT가 오디오, 텍스트, 이미지 또는 이들의 조합을 포함한 다양한 형식의 입력을 허용할 수 있습니다. 또한 다양한 형식으로 응답을 제공할 수도 있습니다. 그러나 가장 인상적인 점은 응답을 제공하는 속도입니다.

새 모델을 사용하면 ChatGPT가 오디오 입력에 응답하는 데 약 320밀리초 이하가 소요됩니다. 이는 사람이 대화에서 응답하는 데 걸리는 시간과 비슷합니다. 이 외에도 영어 사용이나 코드 작성에 관한 한 GPT-4o의 성능은 GPT-4 Turbo와 유사합니다.

또한 영어가 아닌 언어의 텍스트 기반 입력에 응답할 때 훨씬 더 나은 성능을 발휘하며 이전 버전보다 훨씬 더 효율적이기 때문에 API에서 훨씬 저렴합니다.

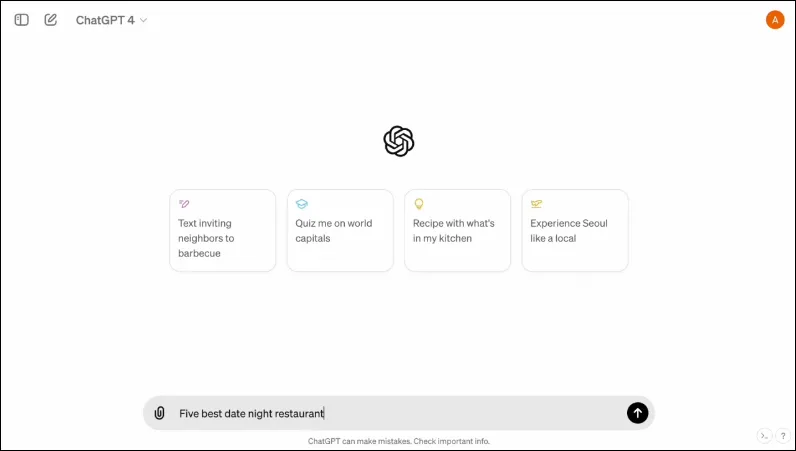

또한 상호 작용을 더 쉽고 깔끔하게 만들 수 있도록 설계된 새로운 인터페이스도 있습니다.

멀티모달이다

ChatGPT의 기존 음성 모드는 세 가지 모델로 구성됩니다. 첫 번째는 텍스트 기반 입력을 받아 동일한 형식으로 출력을 제공하는 반면, 두 번째는 오디오 입력을 텍스트로 변환하여 ChatGPT에서 가져와 텍스트 기반 출력을 제공합니다. 마지막 모델은 텍스트를 오디오로 변환합니다.

그러나 이 설계에서는 모델이 오디오 입력과 직접 상호 작용할 수 없거나 감정적인 요소가 있는 출력을 제시할 수 없기 때문에 정보가 손실됩니다. OpenAI는 GPT-4o를 통해 다양한 유형의 입력을 이해하고 필요한 출력을 직접 처리할 수 있는 단일 다중 모드 모델을 구축했습니다.

현재 50개 언어를 지원하며 API로도 제공될 예정입니다.

인간의 감정을 시뮬레이션할 수 있습니다

ChatGPT가 처음 발표되었을 때 많은 사람들이 AI 챗봇의 가장 큰 단점 중 하나는 감정적인 반응을 제공할 수 없다는 점이었습니다. ChatGPT는 GPT-4o를 통해 인간의 감정을 시뮬레이션하고 그러한 감정을 통합하는 적절한 응답을 제공할 수 있습니다.

OpenAI가 공유한 데모에서 챗봇은 요청에 따라 웃고, 노래하고, 빈정거리는 모습까지 볼 수 있습니다. 이는 현재 다른 AI 챗봇이 할 수 있는 것보다 훨씬 뛰어난 수준이며 사용자 상호 작용을 훨씬 더 즐겁게 만들 것입니다. OpenAI에 따르면, 새로운 모델을 통해 ChatGPT는 사용자의 기분도 감지하고 해당 정보를 기반으로 적절한 응답을 제공할 수 있습니다.

시각적 입력을 사용하는 기능과 결합하여 감정적인 반응을 제공하는 기능은 새 모델이 제공하는 가장 인상적인 기능 중 하나입니다.

새로운 모델은 더 많은 양의 정보를 저장할 수 있습니다

GPT-4o 덕분에 ChatGPT는 이제 차트 및 사진과 같은 이미지를 더 잘 이해할 수 있으며 사용자에 대한 더 많은 정보를 저장할 수 있습니다. 이는 또한 더 큰 텍스트 조각을 포함할 수 있는 응답으로 변환되며, 이는 여러 사용 사례에서 유용할 수 있습니다.

예를 들어, 이제 챗봇에게 더 큰 텍스트를 번역하도록 요청할 수 있으며 실시간 번역에 도움이 될 수 있습니다. 텍스트 기반 입력과 함께 시각적 및 오디오 입력을 사용할 수 있으므로 스크린샷, 사진 및 기타 이미지에서 정보를 수집하는 데 사용할 수 있습니다.

GPT-4o는 사용자가 반복할 필요 없이 더 많은 양의 정보를 저장할 수 있기 때문에 사용자는 AI 챗봇과 주고받는 대화에 참여할 수 있습니다. 정보가 많을수록 사용자는 대화가 더욱 정교해질 것으로 기대할 수 있습니다.

새 모델의 보호 장치

기존 GPT 모델과 마찬가지로 GPT-4o는 안전을 보장하기 위해 특정 보호 장치를 염두에 두고 설계되었습니다. 훈련 데이터가 필터링되었으며 훈련 후 모델의 작동 방식이 개선되었습니다. OpenAI는 또한 원치 않는 사고를 방지하기 위해 사이버 보안 및 설득과 같은 여러 매개변수에 걸쳐 AI 모델을 평가했습니다.

그 외에도 개발자들은 잘못된 정보, 사회심리학 등 다양한 분야의 전문가 70여명의 도움을 받아 새로운 모델에서 발생하거나 증가할 수 있는 위험을 식별하고 완화했습니다. 또한 향후 위험에 대비하여 챗봇 사용을 계속 모니터링하고 필요할 때 필요한 조치를 취할 것입니다.

우선 OpenAI는 제한된 음성 모델 사전 설정만 제공합니다. 또한 모델을 개선하고 완전한 안전을 보장하기 위해 사용자가 제공한 피드백을 고려합니다.

GPT-4o 가용성

지금까지 ChatGPT에는 GPT 3.5에서 실행되는 무료 버전과 GPT 4.0에서 실행되고 월 20달러의 비용이 드는 유료 버전의 두 가지 버전이 있었습니다. 후자는 더 큰 언어 모델에 액세스하여 더 많은 양의 데이터를 처리할 수 있습니다.

GPT-4o는 무료 사용자와 유료 사용자 모두에게 제공될 예정이며 앞으로 몇 주 안에 기기에 출시될 예정입니다. 모바일 기기에서는 기존 앱을 통해 업데이트될 예정이며, 데스크톱 사용자를 위한 웹 버전 외에 새로운 macOS 데스크톱 앱도 출시될 예정이다(윈도우 버전은 올해 말 출시 예정).

무료 사용자와 유료 사용자를 구별하기 위해 OpenAI는 유료 사용자에게 무료 사용자에게 제공되는 것보다 5배 더 많은 용량을 제공할 것입니다. 한도를 초과하면 ChatGPT 3.5로 다시 전환됩니다.

GPT-40에 관한 OpenAI의 발표는 Google이 자체적으로 AI 관련 발표를 할 것으로 예상되는 Google의 연례 I/O 개발자 컨퍼런스 하루 전에 나왔습니다. OpenAI는 또한 더 많은 발표가 예정되어 있다고 약속했기 때문에 두 경쟁자 간의 경쟁이 이제 막 뜨거워지기 시작했다는 것은 의심의 여지가 없습니다.

OpenAI가 AI 모델에 대한 추가 변경 사항을 언제 공개할지는 알 수 없지만 GPT-4o가 전 세계적으로 ChatGPT를 실행하는 장치로 향하고 있다는 것은 알고 있습니다. 따라서 손가락을 교차시키고 업데이트가 장치에 나타날 때까지 기다리십시오. 다음 시간까지!

답글 남기기